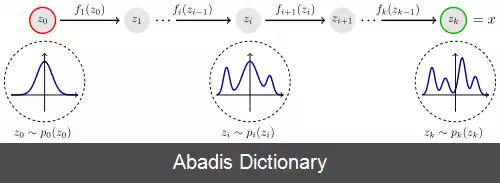

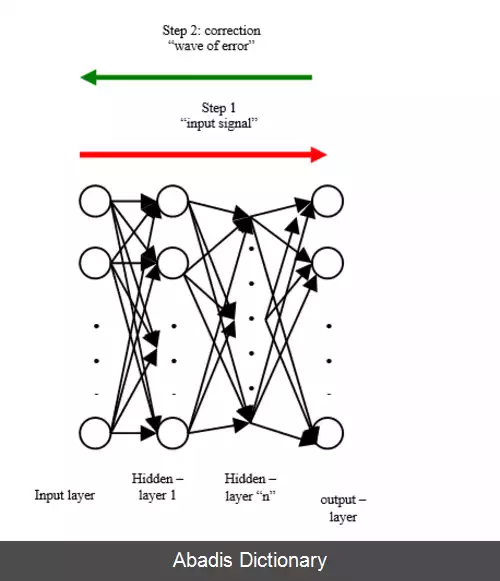

نرمال سازی دسته ای یا batch normalization یک تکنیک است که روی ورودی هر لایه شبکه عصبی مصنوعی اعمال می شود که از طریق تغییر مرکز توزیع دیتاها یا تغییر دادن مقیاس آنها موجب سریعتر و پایدارتر شدن شبکه عصبی می شود. این تکنیک در سال 2015 توسط سرگئی یوفه وکریستین سگدی معرفی شد. [ ۱]

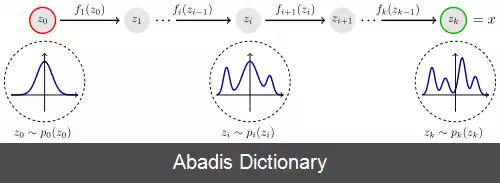

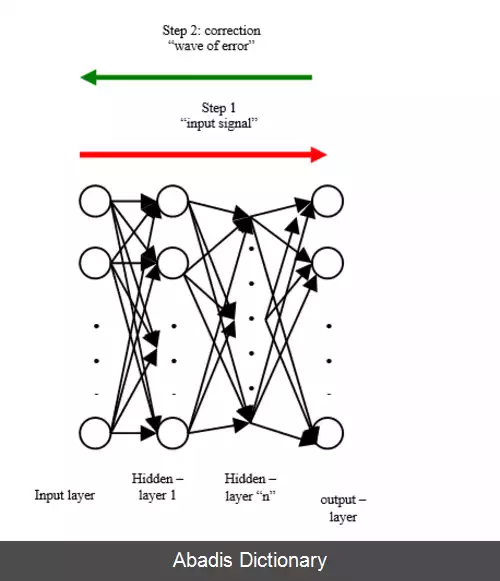

تاثیر کارایی این روش هنوز بطور دقیق مشخص نیست ولی باور دارند که موجب کاهش اثر شیفت توزیع داخلی یا internal covariate shift می شود. به این صورت که وقتی خروجی یک لایه شبکه میخواهد وارد ورودی شبکه دیگر بشود، به وسیله ی تابع فعال ساز ممکن است شکل توزیع به هم بخورد و هر بار این شکل توزیع در بهینه سازی پارامترهای لایه بعد نیز موثر باشد، ولی وقتی از نرمال سازی دسته ای استفاده می شود، اثر توزیع گرفته می شود. [ ۲] با این وجود نرمال سازی دسته ای موجب انفجار گرادیانت می شود که توسط اقداماتی از جمله اتصال پرشی در شبکه های باقی مانده یا residual network حل می شود. [ ۳] امروزه روش هایی از جمله گرادیانت کلیپینگ و تنظیم کننده هوشمند ابرپارامترها درکنار ویا بجای نرمال سازی دسته ای استفاده می شوند و ضعف های این روش را پوشش می دهند. [ ۴] [ ۵]

به تغییر توزیع ورودی در سیستم های یادگیری اثر شیفت توزیع می گوییم. حال اگر این اتفاق در سطح نورون ها در شبکه عصبی اتفاق بیفتد، آنرا اثر شیفت توزیع داخلی می نامیم.

این موضوع در تمامی شبکه های عصبی بصورت کم و بیش وجود دارد ولی وقتی شبکه نورن ها طویل می شود، آنگاه نمود بیشتری پیدا می کند، درست مانند داستان یک کلاغ و چهل کلاغ. یکی از مثال های کلاسیک در این زمینه عبارت است از زمانی که در شبکه عصبی، داده های آموزش ما همگی بصورت سیاه و سفید باشد ولی در زمان تست داده هایی بصورت رنگی و . . . بدهیم. این مسئله باعث می شود مدل ما کارایی خود را به دلیل مشکل اثر شیفت توزیع داخلی از دست بدهد. [ ۶] بنابراین، روش نرمال سازی دسته ای برای کاهش این جابجایی های ناخواسته برای سرعت بخشیدن به آموزش و تولید مدل های قابل اعتمادتر پیشنهاد شده است.

اعتقاد بر این است که علاوه بر کاهش تغییر متغیر داخلی، نرمال سازی دسته ای مزایای دیگری نیز به همراه دارد. با این عملیات اضافی، شبکه می تواند از نرخ یادگیری بالاتر بدون ناپدید شدن یا انفجار شیب استفاده کند. علاوه بر این، به نظر می رسد نرمال سازی دسته ای یک اثر منظم کننده دارد، به طوری که شبکه ویژگی های تعمیم آن را بهبود می بخشد، و بنابراین استفاده از حذف برای کاهش بیش برازش غیرضروری است. همچنین مشاهده شده است که با نرمال سازی دسته ای ، شبکه نسبت به طرح های مختلف اولیه سازی و نرخ های یادگیری انعطاف پذیرتر می شود.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفتاثیر کارایی این روش هنوز بطور دقیق مشخص نیست ولی باور دارند که موجب کاهش اثر شیفت توزیع داخلی یا internal covariate shift می شود. به این صورت که وقتی خروجی یک لایه شبکه میخواهد وارد ورودی شبکه دیگر بشود، به وسیله ی تابع فعال ساز ممکن است شکل توزیع به هم بخورد و هر بار این شکل توزیع در بهینه سازی پارامترهای لایه بعد نیز موثر باشد، ولی وقتی از نرمال سازی دسته ای استفاده می شود، اثر توزیع گرفته می شود. [ ۲] با این وجود نرمال سازی دسته ای موجب انفجار گرادیانت می شود که توسط اقداماتی از جمله اتصال پرشی در شبکه های باقی مانده یا residual network حل می شود. [ ۳] امروزه روش هایی از جمله گرادیانت کلیپینگ و تنظیم کننده هوشمند ابرپارامترها درکنار ویا بجای نرمال سازی دسته ای استفاده می شوند و ضعف های این روش را پوشش می دهند. [ ۴] [ ۵]

به تغییر توزیع ورودی در سیستم های یادگیری اثر شیفت توزیع می گوییم. حال اگر این اتفاق در سطح نورون ها در شبکه عصبی اتفاق بیفتد، آنرا اثر شیفت توزیع داخلی می نامیم.

این موضوع در تمامی شبکه های عصبی بصورت کم و بیش وجود دارد ولی وقتی شبکه نورن ها طویل می شود، آنگاه نمود بیشتری پیدا می کند، درست مانند داستان یک کلاغ و چهل کلاغ. یکی از مثال های کلاسیک در این زمینه عبارت است از زمانی که در شبکه عصبی، داده های آموزش ما همگی بصورت سیاه و سفید باشد ولی در زمان تست داده هایی بصورت رنگی و . . . بدهیم. این مسئله باعث می شود مدل ما کارایی خود را به دلیل مشکل اثر شیفت توزیع داخلی از دست بدهد. [ ۶] بنابراین، روش نرمال سازی دسته ای برای کاهش این جابجایی های ناخواسته برای سرعت بخشیدن به آموزش و تولید مدل های قابل اعتمادتر پیشنهاد شده است.

اعتقاد بر این است که علاوه بر کاهش تغییر متغیر داخلی، نرمال سازی دسته ای مزایای دیگری نیز به همراه دارد. با این عملیات اضافی، شبکه می تواند از نرخ یادگیری بالاتر بدون ناپدید شدن یا انفجار شیب استفاده کند. علاوه بر این، به نظر می رسد نرمال سازی دسته ای یک اثر منظم کننده دارد، به طوری که شبکه ویژگی های تعمیم آن را بهبود می بخشد، و بنابراین استفاده از حذف برای کاهش بیش برازش غیرضروری است. همچنین مشاهده شده است که با نرمال سازی دسته ای ، شبکه نسبت به طرح های مختلف اولیه سازی و نرخ های یادگیری انعطاف پذیرتر می شود.

wiki: نرمال سازی دسته ای