در هوش مصنوعی، تابع فعالسازی یک گره، خروجی آن گره را با یک ورودی یا مجموعه ای از ورودی ها تعریف می کند. یک مدار مجتمع استاندارد می تواند به عنوان یک الکترونیک دیجیتال از توابع فعال سازی دیده شود که بسته به ورودی می تواند «روشن» ( ۱ ) یا «خاموش» ( ۰ ) باشد. این مشابه پرسپترون خطی در شبکه های عصبی است. با این حال، تنها توابع فعال سازی غیرخطی به چنین شبکه هایی اجازه می دهند تا مسائل غیر ضروری را تنها با استفاده از تعداد کمی از گره ها محاسبه کنند و چنین توابع فعال سازی غیرخطی نامیده می شوند. [ ۱]

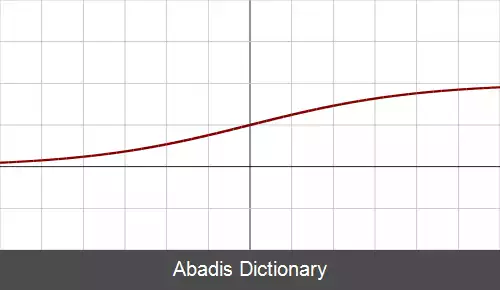

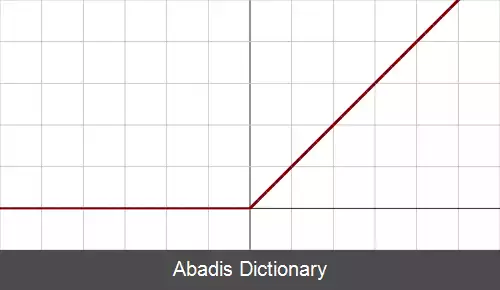

رایج ترین توابع فعالسازی را در شبکه عصبی می توان می توان به سه دسته تقسیم کرد: توابع فعالسازی پله ای، توابع فعالسازی خطی، توابع فعالسازی غیر خطی. [ ۲]

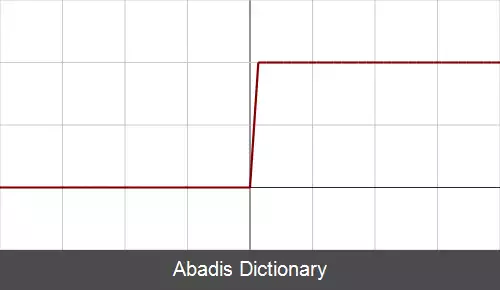

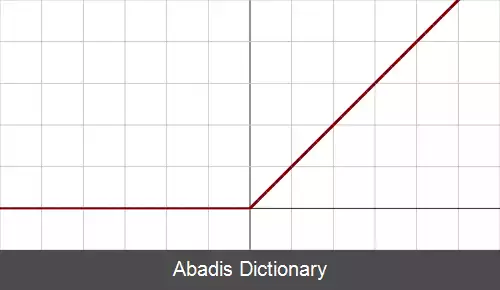

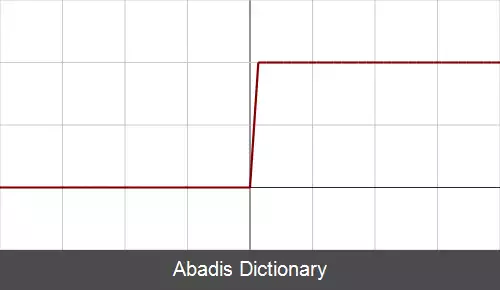

در این نوع توابع، ابتدا یک آستانه ای در نظر گرفته می شود و با توجه به آن تعیین می شود که آیا گره فعال می شود یا خیر. این نوع توابع در دامنه ای که مشتق پذیر هستند، مشتقی برابر صفر دارند و به همین دلیل استفاده از روند پس انتشار برای آن ها با مشکل همراه است.

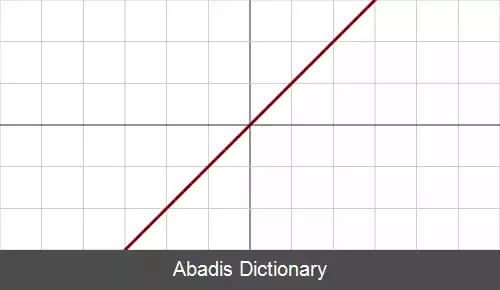

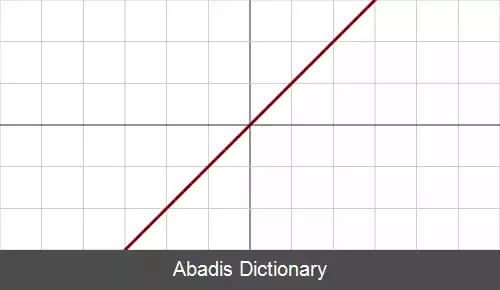

این نوع توابع، جمع ورودی های هر گره را در خروجی قرار می دهد. این توابع مقادیر ورودی را در بازه خاصی قرار نمی دهند. در این نوع توابع نیز به این دلیل که مشتق برابر یک عدد ثابت است نمی توان از روند پس انتشار استفاده کرد. در زمان هایی که پارامترها و داده های مسئله زیاد و پیچیده می شوند استفاده از این نوع توابع فعالسازی توصیه نمی شود.

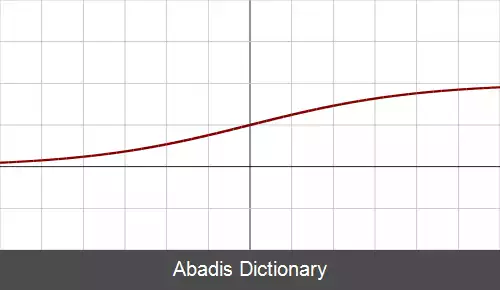

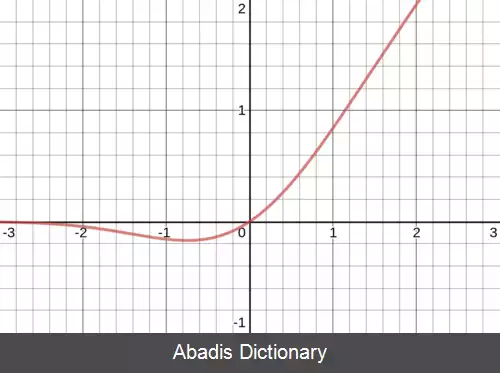

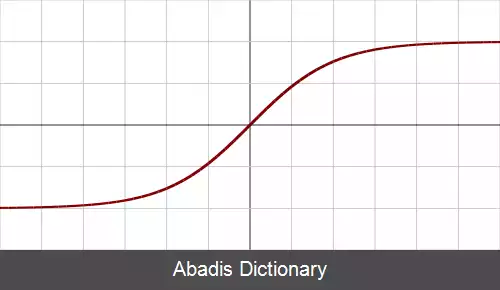

این نوع توابع بیشتر از سایر توابع فعالسازی در شبکه های عصبی مورد استفاده قرار می گیرند و وفق پذیری بالایی با داده های پیچیده ورودی دارند. در این نوع توابع استفاده از روند پس انتشار به راحتی امکان پذیر است.

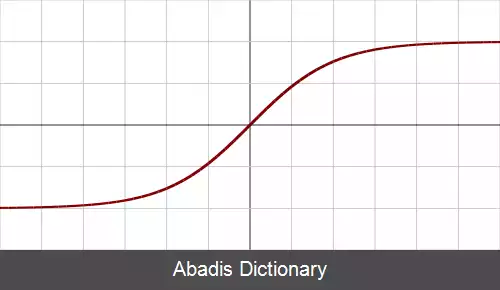

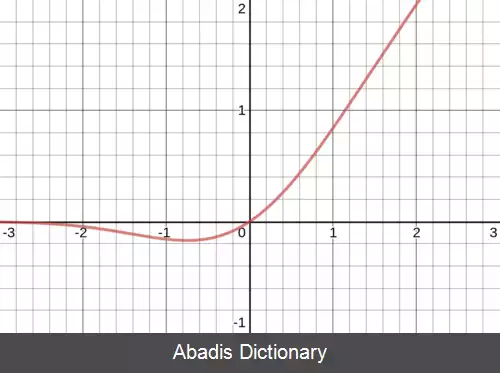

توابع فعال سازی متعددی وجود دارد. مقاله اصلی هینتون و همکاران در سال ۲۰۱۲ در مورد تشخیص خودکار گفتار از یک تابع فعال سازی لجستیک سیگموئید استفاده می کند. [ ۳] معماری چشم انداز کامپیوتر AlexNet 2012 از تابع فعال سازی یکسوساز استفاده می کند، همان طور که ResNet معماری بینایی کامپیوتری Seminal 2015 نیز استفاده می کند. مدل پردازش زبان اولیه 2018 BERT از نسخه روان ReLU، یعنی GELU استفاده می کند. [ ۴]

علاوه بر عملکرد تجربی، توابع فعالسازی دارای ویژگی های ریاضی مختلفی نیز هستند:

غیرخطی

وقتی تابع فعال سازی غیرخطی است، می توان ثابت کرد که یک شبکه عصبی دو لایه یک تقریب کننده تابع جهانی است. [ ۵] این به عنوان قضیه تقریب جهانی شناخته می شود. تابع فعال سازی هویت این ویژگی را برآورده نمی کند. وقتی چندین لایه از تابع فعال سازی هویت استفاده می کنند، کل شبکه معادل یک مدل تک لایه است.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفرایج ترین توابع فعالسازی را در شبکه عصبی می توان می توان به سه دسته تقسیم کرد: توابع فعالسازی پله ای، توابع فعالسازی خطی، توابع فعالسازی غیر خطی. [ ۲]

در این نوع توابع، ابتدا یک آستانه ای در نظر گرفته می شود و با توجه به آن تعیین می شود که آیا گره فعال می شود یا خیر. این نوع توابع در دامنه ای که مشتق پذیر هستند، مشتقی برابر صفر دارند و به همین دلیل استفاده از روند پس انتشار برای آن ها با مشکل همراه است.

این نوع توابع، جمع ورودی های هر گره را در خروجی قرار می دهد. این توابع مقادیر ورودی را در بازه خاصی قرار نمی دهند. در این نوع توابع نیز به این دلیل که مشتق برابر یک عدد ثابت است نمی توان از روند پس انتشار استفاده کرد. در زمان هایی که پارامترها و داده های مسئله زیاد و پیچیده می شوند استفاده از این نوع توابع فعالسازی توصیه نمی شود.

این نوع توابع بیشتر از سایر توابع فعالسازی در شبکه های عصبی مورد استفاده قرار می گیرند و وفق پذیری بالایی با داده های پیچیده ورودی دارند. در این نوع توابع استفاده از روند پس انتشار به راحتی امکان پذیر است.

توابع فعال سازی متعددی وجود دارد. مقاله اصلی هینتون و همکاران در سال ۲۰۱۲ در مورد تشخیص خودکار گفتار از یک تابع فعال سازی لجستیک سیگموئید استفاده می کند. [ ۳] معماری چشم انداز کامپیوتر AlexNet 2012 از تابع فعال سازی یکسوساز استفاده می کند، همان طور که ResNet معماری بینایی کامپیوتری Seminal 2015 نیز استفاده می کند. مدل پردازش زبان اولیه 2018 BERT از نسخه روان ReLU، یعنی GELU استفاده می کند. [ ۴]

علاوه بر عملکرد تجربی، توابع فعالسازی دارای ویژگی های ریاضی مختلفی نیز هستند:

غیرخطی

وقتی تابع فعال سازی غیرخطی است، می توان ثابت کرد که یک شبکه عصبی دو لایه یک تقریب کننده تابع جهانی است. [ ۵] این به عنوان قضیه تقریب جهانی شناخته می شود. تابع فعال سازی هویت این ویژگی را برآورده نمی کند. وقتی چندین لایه از تابع فعال سازی هویت استفاده می کنند، کل شبکه معادل یک مدل تک لایه است.

wiki: تابع فعالسازی