یادگیری نیمه نظارتی دسته ای از روش های یادگیری ماشین است که در آن از داده های بدون برچسب و داده های برچسب دار به صورت هم زمان برای بهبود دقت یادگیری استفاده می شود.

روش های یادگیری نیمه نظارتی را در یک دسته بندی کلی به دسته های زیر می توان تقسیم کرد. [ ۱]

در روش های مولد[ ۲] ابتدا یک مدل پارامتری برای تابع توزیع نقاط ( مثلاً توزیع گاوسی ) انتخاب می شود که آن را با P ( x | y , θ ) نشان می دهیم که در آن θ مدل است. سپس P ( y ) از روی داده های برچسب دار تخمین زده می شود. احتمال وقوع نقاط با توجه به تابع توزیع هر دسته، بر حسب پارامترهای مدل، به صورت تحلیلی محاسبه می شود. سپس با اعمال قانون بیز می توان تابع توزیع برچسب در هر نقطه را محاسبه کرد. در روش های مولد معمولاً هدف بیشینه کردن این احتمال وقوع یا به طور معادل بیشینه کردن راست نمایی[ ۳] آن ها نسبت به پارامترهای مدل است. از روش های مختلفی می توان برای بهینه کردن پارامترهای مدل نسبت به میزان راست نمایی استفاده کرد.

در مقابل روش های مولد، روش هایی که به طور مستقیم به یادگیری P ( y | x ) می پردازند یا روش های تمایزی[ ۴] هستند. توجیهات نظری وجود دارد که نشان می دهد که روش های مولد نیاز به داده های بیشتری نسبت به روش های تمایزی جهت یادگیری دارند. همچنین در عمل روش های تمایزی موفق تر نشان داده اند؛ بنابراین تحقیقات روی روش های مولد کم رنگ بوده است.

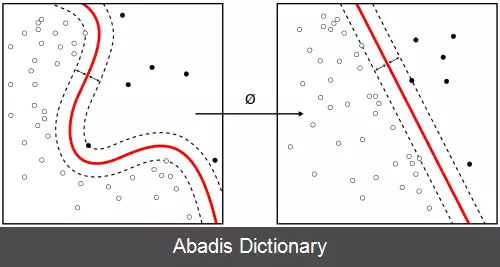

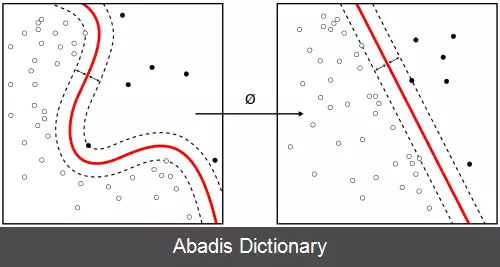

همان طور که گفته شد، فرض خوشه با فرض جداسازی کم چگالی معادل است. با توجه به این نکته می توان عبارت های منظم سازی تعریف کرد که وجود مرز طبقه بندی در نقاط پرچگالی را جریمه می کنند. به این ترتیب الگوریتم های زیادی برای یادگیری نیمه نظارتی مطرح می شوند. معروف ترین الگوریتم در این دسته از روش ها، الگوریتم TSVM است، که در سال ۱۹۹۸ توسط وپنیک ارائه شد. وپنیک از مفهوم ابعاد VC و قاعدهٔ SRM، [ ۵] برای طراحی یک مسئله بهینه سازی مشابه مسئلهٔ بهینه سازی SVM بهره گرفته است. مسئلهٔ بهینه سازی TSVM، مسئله ای پیچیده است و تاکنون الگوریتمی کارا برای یافتن جواب بهینهٔ عمومی آن ارائه نشده است. روش های دیگری هم در حوزهٔ استفاده صرف از فرض خوشه استفاده شده اند که شامل می شوند. همهٔ این روش ها در دو خاصیت مشترکند، یکی اینکه برای طبقه بندی طراحی شده اند و اینکه طراحی آن ها حول مفهوم مرز جداساز و اندازه مرز بوده است.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفروش های یادگیری نیمه نظارتی را در یک دسته بندی کلی به دسته های زیر می توان تقسیم کرد. [ ۱]

در روش های مولد[ ۲] ابتدا یک مدل پارامتری برای تابع توزیع نقاط ( مثلاً توزیع گاوسی ) انتخاب می شود که آن را با P ( x | y , θ ) نشان می دهیم که در آن θ مدل است. سپس P ( y ) از روی داده های برچسب دار تخمین زده می شود. احتمال وقوع نقاط با توجه به تابع توزیع هر دسته، بر حسب پارامترهای مدل، به صورت تحلیلی محاسبه می شود. سپس با اعمال قانون بیز می توان تابع توزیع برچسب در هر نقطه را محاسبه کرد. در روش های مولد معمولاً هدف بیشینه کردن این احتمال وقوع یا به طور معادل بیشینه کردن راست نمایی[ ۳] آن ها نسبت به پارامترهای مدل است. از روش های مختلفی می توان برای بهینه کردن پارامترهای مدل نسبت به میزان راست نمایی استفاده کرد.

در مقابل روش های مولد، روش هایی که به طور مستقیم به یادگیری P ( y | x ) می پردازند یا روش های تمایزی[ ۴] هستند. توجیهات نظری وجود دارد که نشان می دهد که روش های مولد نیاز به داده های بیشتری نسبت به روش های تمایزی جهت یادگیری دارند. همچنین در عمل روش های تمایزی موفق تر نشان داده اند؛ بنابراین تحقیقات روی روش های مولد کم رنگ بوده است.

همان طور که گفته شد، فرض خوشه با فرض جداسازی کم چگالی معادل است. با توجه به این نکته می توان عبارت های منظم سازی تعریف کرد که وجود مرز طبقه بندی در نقاط پرچگالی را جریمه می کنند. به این ترتیب الگوریتم های زیادی برای یادگیری نیمه نظارتی مطرح می شوند. معروف ترین الگوریتم در این دسته از روش ها، الگوریتم TSVM است، که در سال ۱۹۹۸ توسط وپنیک ارائه شد. وپنیک از مفهوم ابعاد VC و قاعدهٔ SRM، [ ۵] برای طراحی یک مسئله بهینه سازی مشابه مسئلهٔ بهینه سازی SVM بهره گرفته است. مسئلهٔ بهینه سازی TSVM، مسئله ای پیچیده است و تاکنون الگوریتمی کارا برای یافتن جواب بهینهٔ عمومی آن ارائه نشده است. روش های دیگری هم در حوزهٔ استفاده صرف از فرض خوشه استفاده شده اند که شامل می شوند. همهٔ این روش ها در دو خاصیت مشترکند، یکی اینکه برای طبقه بندی طراحی شده اند و اینکه طراحی آن ها حول مفهوم مرز جداساز و اندازه مرز بوده است.

wiki: یادگیری نیمه نظارتی