مدل های انتشاری ( به انگلیسی: Diffusion Models ) در یادگیری ماشینی، دسته ای از مدل های متغیر پنهان ( به انگلیسی: Latent Variable Models ) هستند. این مدل ها نوعی زنجیره مارکوف هستند که با استفاده از استنباط بیزی تغییراتی آموزش داده می شوند. [ ۱] هدف مدل های انتشاری، یادگیری ساختار پنهان یک مجموعه داده با مدل سازی روشی است که در آن نقاط داده در فضای پنهان ( به انگلیسی: latent space ) منتشر می شوند. در بینایی ماشین، این یعنی یک شبکه عصبی آموزش داده می شود تا با یادگیری معکوس فرایند انتشاری، با شروع از نویز گاوسی به تصاویر اصلی برسد. [ ۲] [ ۳]

مدل های انتشاری در سال ۲۰۱۵ با ایده گرفتن از ترمودینامیک غیرتعادلی معرفی شدند.

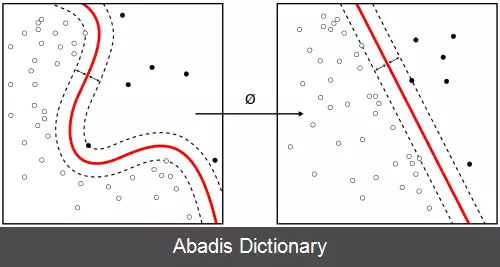

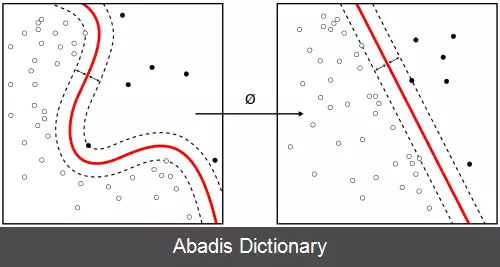

مدل های انتشاری خانواده ای از مدل های مولد احتمالی هستند که به تدریج داده ها را با اضافه کردن نویز تخریب می کنند، سپس یادمی گیرند که این فرایند را برای تولید نمونه معکوس کنند. یک مدل انتشاری از دو زنجیره مارکوف استفاده می کند: یک زنجیره مستقیم که داده ها را به تدریج به نویز تبدیل می کند و یک زنجیره معکوس که نویز را به داده تبدیل می کند. اولی معمولاً با هدف تبدیل هر توزیع داده ای به یک توزیع پیشین ساده ( مثلاً گاوسی استاندارد ) به صورت دستی طراحی می شود، در حالی که زنجیره مارکوف دوم با یادگیری هسته های انتقال توسط شبکه های عصبی عمیق، اولی را معکوس می کند. [ ۴]

با داشتن یک نقطه داده نمونه برداری شده از یک توزیع داده واقعی x 0 ∼ q ( x ) ، فرایند انتشار مستقیم ( به انگلیسی: forward diffusion process ) را این گونه تعریف می کنیم که در آن مقدار کمی نویز گاوسی را در T گام به نمونه ورودی اضافه می کنیم تا نمونه های نویزدار x 1 , … , x T تولید شود. اندازه گام ها توسط یک برنامه واریانس { β t ∈ ( 0 , 1 ) } t = 1 T کنترل می شود.

q ( x t | x t − 1 ) = N ( x t ; 1 − β t x t − 1 , β t I ) q ( x 1 : T | x 0 ) = ∏ t = 1 T q ( x t | x t − 1 )

نمونه داده به تدریج ویژگی های قابل مشاهده خود را با بزرگتر شدن گام t از دست می دهد. درنهایت وقتی T → ∞ ، x T معادل یک توزیع گاوسی همسان گرد خواهد شد.

یک ویژگی خوب فرایند فوق این است که می توانیم x t را در هر گام دلخواه t به صورت فرم بسته زیر با فرض α t = 1 − β t و α ¯ t = ∏ i = 1 t α i محاسبه کنیم:[ ۵]

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفمدل های انتشاری در سال ۲۰۱۵ با ایده گرفتن از ترمودینامیک غیرتعادلی معرفی شدند.

مدل های انتشاری خانواده ای از مدل های مولد احتمالی هستند که به تدریج داده ها را با اضافه کردن نویز تخریب می کنند، سپس یادمی گیرند که این فرایند را برای تولید نمونه معکوس کنند. یک مدل انتشاری از دو زنجیره مارکوف استفاده می کند: یک زنجیره مستقیم که داده ها را به تدریج به نویز تبدیل می کند و یک زنجیره معکوس که نویز را به داده تبدیل می کند. اولی معمولاً با هدف تبدیل هر توزیع داده ای به یک توزیع پیشین ساده ( مثلاً گاوسی استاندارد ) به صورت دستی طراحی می شود، در حالی که زنجیره مارکوف دوم با یادگیری هسته های انتقال توسط شبکه های عصبی عمیق، اولی را معکوس می کند. [ ۴]

با داشتن یک نقطه داده نمونه برداری شده از یک توزیع داده واقعی x 0 ∼ q ( x ) ، فرایند انتشار مستقیم ( به انگلیسی: forward diffusion process ) را این گونه تعریف می کنیم که در آن مقدار کمی نویز گاوسی را در T گام به نمونه ورودی اضافه می کنیم تا نمونه های نویزدار x 1 , … , x T تولید شود. اندازه گام ها توسط یک برنامه واریانس { β t ∈ ( 0 , 1 ) } t = 1 T کنترل می شود.

q ( x t | x t − 1 ) = N ( x t ; 1 − β t x t − 1 , β t I ) q ( x 1 : T | x 0 ) = ∏ t = 1 T q ( x t | x t − 1 )

نمونه داده به تدریج ویژگی های قابل مشاهده خود را با بزرگتر شدن گام t از دست می دهد. درنهایت وقتی T → ∞ ، x T معادل یک توزیع گاوسی همسان گرد خواهد شد.

یک ویژگی خوب فرایند فوق این است که می توانیم x t را در هر گام دلخواه t به صورت فرم بسته زیر با فرض α t = 1 − β t و α ¯ t = ∏ i = 1 t α i محاسبه کنیم:[ ۵]

wiki: مدل های انتشاری