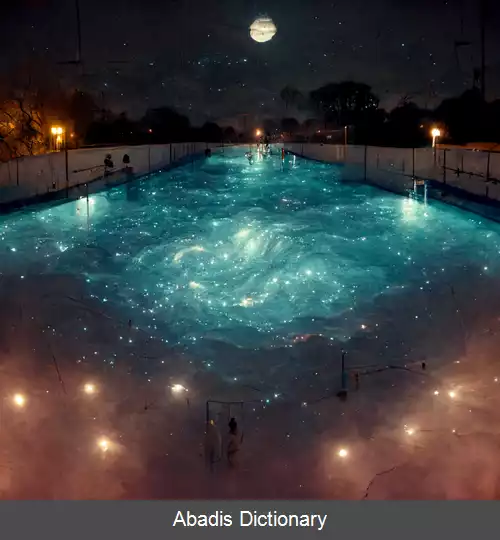

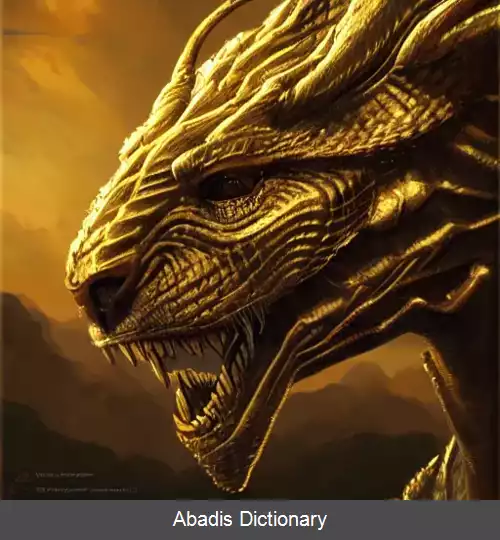

مدل متن به تصویر یک مدل یادگیری ماشینی است که یک توصیف زبان طبیعی را به عنوان ورودی می گیرد و تصویری مطابق با آن توصیف تولید می کند. این مدل ها در اواسط دهه 2010 در نتیجه پیشرفت در شبکه های عصبی عمیق شروع به توسعه کردند. در سال 2022، خروجی به روز ترین مدل های تبدیل متن به تصویر، مانند مدل DALL - E 2 از Open AI ، Imagen از Google Brain و Stable Diffusion از StabilityAI به کیفیت عکس های واقعی و نقاشی های انسانی نزدیک تر شدند.

مدل های متن به تصویر عموماً یک مدل زبان ، که متن ورودی را به یک نمایش پنهان تبدیل می کند، و یک مدل تصویر تولیدی که یک تصویر براساس آن نمایش تولید می کند را ترکیب میکنند. مؤثرترین مدل ها عموماً بر روی مقادیر انبوهی از داده های تصویر و متن استخراج شده از وب آموزش داده شده اند. [ ۲]

قبل از ظهور یادگیری عمیق، تلاش ها برای ساخت مدل های متن به تصویر به ساخت کلاژ با کنار هم قرار دادن تصاویر تشکیل دهنده ی موجود، مانند پایگاه داده های کلیپ آرت محدود می شد. [ ۳] [ ۴]

برعکس این عمل که نوشتن شرح تصویر نام دارد ، قابل انجام تر بود و تعدادی از مدل های یادگیری عمیق شرح تصویر، قبل از اولین مدل های متن به تصویر وجود داشتند. [ ۵]

اولین مدل مدرن متن به تصویر، alignDRAW، در سال 2015 توسط محققان دانشگاه تورنتو معرفی شد. alignDRAW معماری DRAW را که قبلاً معرفی شده بود ( که از رمزگذار خودکار متغیر تکراری با مکانیزم توجه استفاده می کرد ) گسترش داد تا به دنباله های متنی مشروط شود. تصاویر تولید شده توسط alignDRAW تار و غیر واقعی بودند، اما مدل قادر بود به اشیایی که در داده های آموزشی نشان داده نشده اند تعمیم یابد ( مانند اتوبوس مدرسه ی قرمز رنگ ) ، و به طور مناسب از پس ورودی های جدید مانند "تابلوی علامت توقف که در حال پرواز در آسمان آبی است " برآمد. این موضوع نشان می دهد که مدل صرفاً داده های مجموعه آموزشی را«به خاطر » نمی سپرده است.

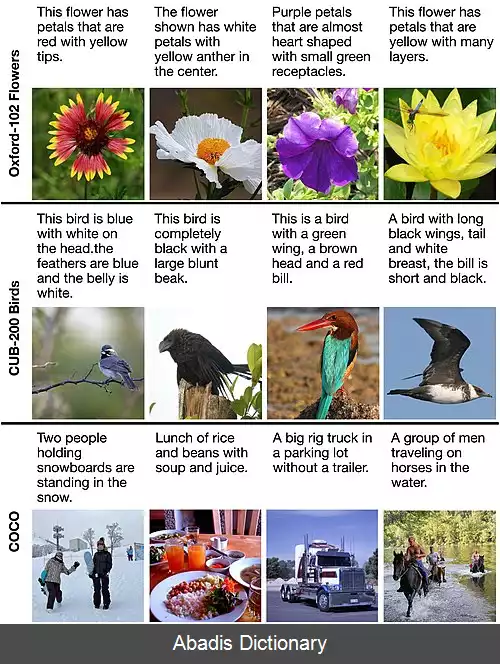

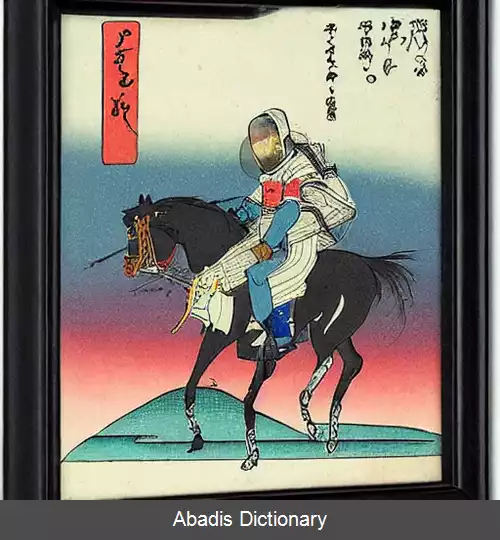

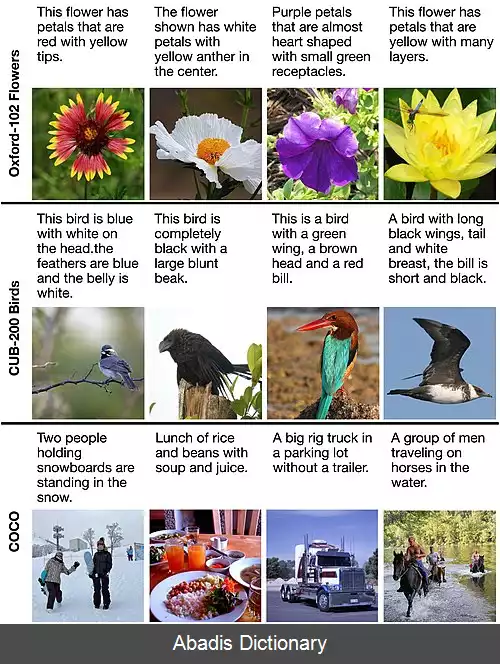

در سال 2016، رید، آکاتا، یان و همکاران. اولین کسانی بودند که از شبکه های متخاصم مولد برای کار متن به تصویر استفاده کردند. آن ها با مدل هایی که بر روی مجموعه داده های محدود و مخصوص به حوزه های خاص آموزش دیده بودند، توانستند تصاویر « قابل قبول بصری» از پرندگان و گل ها را از زیرنویس هایی مانند «پرنده ای تماماً سیاه با یک منقار ضخیم و گرد متمایز» تولید کنند. یک مدل آموزش دیده بر روی مجموعه داده های متنوع تر COCO ، تصاویری را تولید کرد که "از دور. . . دلگرم کننده"، اما فاقد انسجام در جزئیات بودند. سیستم هایی که بعدا به وجود آمدند عبارتند از VQGAN+CLIP، XMC - GAN , و GauGAN2.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفمدل های متن به تصویر عموماً یک مدل زبان ، که متن ورودی را به یک نمایش پنهان تبدیل می کند، و یک مدل تصویر تولیدی که یک تصویر براساس آن نمایش تولید می کند را ترکیب میکنند. مؤثرترین مدل ها عموماً بر روی مقادیر انبوهی از داده های تصویر و متن استخراج شده از وب آموزش داده شده اند. [ ۲]

قبل از ظهور یادگیری عمیق، تلاش ها برای ساخت مدل های متن به تصویر به ساخت کلاژ با کنار هم قرار دادن تصاویر تشکیل دهنده ی موجود، مانند پایگاه داده های کلیپ آرت محدود می شد. [ ۳] [ ۴]

برعکس این عمل که نوشتن شرح تصویر نام دارد ، قابل انجام تر بود و تعدادی از مدل های یادگیری عمیق شرح تصویر، قبل از اولین مدل های متن به تصویر وجود داشتند. [ ۵]

اولین مدل مدرن متن به تصویر، alignDRAW، در سال 2015 توسط محققان دانشگاه تورنتو معرفی شد. alignDRAW معماری DRAW را که قبلاً معرفی شده بود ( که از رمزگذار خودکار متغیر تکراری با مکانیزم توجه استفاده می کرد ) گسترش داد تا به دنباله های متنی مشروط شود. تصاویر تولید شده توسط alignDRAW تار و غیر واقعی بودند، اما مدل قادر بود به اشیایی که در داده های آموزشی نشان داده نشده اند تعمیم یابد ( مانند اتوبوس مدرسه ی قرمز رنگ ) ، و به طور مناسب از پس ورودی های جدید مانند "تابلوی علامت توقف که در حال پرواز در آسمان آبی است " برآمد. این موضوع نشان می دهد که مدل صرفاً داده های مجموعه آموزشی را«به خاطر » نمی سپرده است.

در سال 2016، رید، آکاتا، یان و همکاران. اولین کسانی بودند که از شبکه های متخاصم مولد برای کار متن به تصویر استفاده کردند. آن ها با مدل هایی که بر روی مجموعه داده های محدود و مخصوص به حوزه های خاص آموزش دیده بودند، توانستند تصاویر « قابل قبول بصری» از پرندگان و گل ها را از زیرنویس هایی مانند «پرنده ای تماماً سیاه با یک منقار ضخیم و گرد متمایز» تولید کنند. یک مدل آموزش دیده بر روی مجموعه داده های متنوع تر COCO ، تصاویری را تولید کرد که "از دور. . . دلگرم کننده"، اما فاقد انسجام در جزئیات بودند. سیستم هایی که بعدا به وجود آمدند عبارتند از VQGAN+CLIP، XMC - GAN , و GauGAN2.

wiki: مدل متن به تصویر