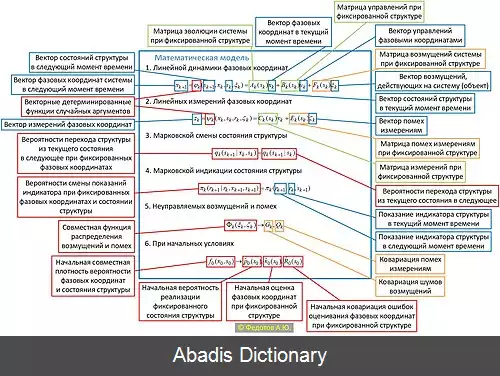

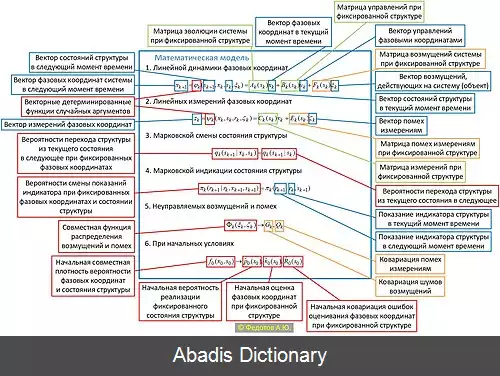

در نظریه احتمال، یک مدل مارکوف یک مدل تصادفی است که برای مدل سازی سیستم های با تغییر شبه تصادفی استفاده می شود. فرض بر این است که وضعیت های آینده فقط به وضعیت فعلی بستگی دارد، نه به رویدادهایی که قبل از آن رخ داده است ( یعنی ویژگی مارکوف را فرض می کند ) . به طور کلی، این فرض استدلال و محاسبات را با مدلی که در غیر این صورت غیرقابل حل بود، امکان پذیر می کند. به همین دلیل، در زمینه های مدل سازی پیش بینی کننده و پیش بینی احتمالی، مطلوب است که یک مدل معین ویژگی مارکوف را نشان دهد. [ ۱]

بسته به اینکه آیا هر حالت متوالی مشاهده پذیر است یا نه و اینکه آیا سیستم بر اساس مشاهدات انجام شده تنظیم می شود، چهار مدل رایج مارکوف در موقعیت های مختلف استفاده می شود:

ساده ترین مدل مارکوف زنجیره مارکوف است. وضعیت یک سیستم را با یک متغیر تصادفی که در طول زمان تغییر می کند مدل می کند. در این زمینه، ویژگی مارکوف نشان می دهد که توزیع برای این متغیر فقط به توزیع یک حالت قبلی بستگی دارد. نمونهٔ استفاده از زنجیره مارکوف، زنجیره مارکوف مونت کارلو است، که از ویژگی مارکوف برای اثبات اینکه یک روش خاص برای انجام یک گام تصادفی از توزیع مشترک نمونه برداری می کند، استفاده می کند.

یک مدل مارکوف پنهان یک زنجیره مارکوف است که وضعیت آن فقط تا حدی مشاهده پذیر است یا به طور پر سر و صدا مشاهده پذیر است. به عبارت دیگر، مشاهدات مربوط به وضعیت سیستم هستند، اما معمولاً برای تعیین دقیق وضعیت کافی نیستند. چندین الگوریتم معروف برای مدل های پنهان مارکوف وجود دارد. به عنوان مثال، با توجه به دنباله ای از مشاهدات، الگوریتم ویتربی محتمل ترین دنباله متناظر از حالت ها را محاسبه می کند، الگوریتم جلورونده احتمال دنباله مشاهدات را محاسبه می کند، و الگوریتم الگوریتم باوم - ولچ احتمالات شروع، تابع انتقال و تابع مشاهده یک مدل مارکوف پنهان را تخمین می زند. یکی از کاربردهای رایج برای تشخیص گفتار است که در آن داده های مشاهده شده شکل موج صوتی گفتار و حالت پنهان متن گفتاری است. در این مثال، الگوریتم ویتربی محتمل ترین دنباله کلمات گفته شده را با توجه به صدای گفتار پیدا می کند.

فرایند تصمیم گیری مارکوف یک زنجیره مارکوف است که در آن انتقال حالت به وضعیت فعلی و بردار عملی که بر روی سیستم اعمال می شود بستگی دارد. به طور معمول، یک فرایند تصمیم مارکوف برای محاسبه سیاست اقداماتی استفاده می شود که برخی از مطلوبیت ها را با توجه به پاداش های مورد انتظار به حداکثر می رساند.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفبسته به اینکه آیا هر حالت متوالی مشاهده پذیر است یا نه و اینکه آیا سیستم بر اساس مشاهدات انجام شده تنظیم می شود، چهار مدل رایج مارکوف در موقعیت های مختلف استفاده می شود:

ساده ترین مدل مارکوف زنجیره مارکوف است. وضعیت یک سیستم را با یک متغیر تصادفی که در طول زمان تغییر می کند مدل می کند. در این زمینه، ویژگی مارکوف نشان می دهد که توزیع برای این متغیر فقط به توزیع یک حالت قبلی بستگی دارد. نمونهٔ استفاده از زنجیره مارکوف، زنجیره مارکوف مونت کارلو است، که از ویژگی مارکوف برای اثبات اینکه یک روش خاص برای انجام یک گام تصادفی از توزیع مشترک نمونه برداری می کند، استفاده می کند.

یک مدل مارکوف پنهان یک زنجیره مارکوف است که وضعیت آن فقط تا حدی مشاهده پذیر است یا به طور پر سر و صدا مشاهده پذیر است. به عبارت دیگر، مشاهدات مربوط به وضعیت سیستم هستند، اما معمولاً برای تعیین دقیق وضعیت کافی نیستند. چندین الگوریتم معروف برای مدل های پنهان مارکوف وجود دارد. به عنوان مثال، با توجه به دنباله ای از مشاهدات، الگوریتم ویتربی محتمل ترین دنباله متناظر از حالت ها را محاسبه می کند، الگوریتم جلورونده احتمال دنباله مشاهدات را محاسبه می کند، و الگوریتم الگوریتم باوم - ولچ احتمالات شروع، تابع انتقال و تابع مشاهده یک مدل مارکوف پنهان را تخمین می زند. یکی از کاربردهای رایج برای تشخیص گفتار است که در آن داده های مشاهده شده شکل موج صوتی گفتار و حالت پنهان متن گفتاری است. در این مثال، الگوریتم ویتربی محتمل ترین دنباله کلمات گفته شده را با توجه به صدای گفتار پیدا می کند.

فرایند تصمیم گیری مارکوف یک زنجیره مارکوف است که در آن انتقال حالت به وضعیت فعلی و بردار عملی که بر روی سیستم اعمال می شود بستگی دارد. به طور معمول، یک فرایند تصمیم مارکوف برای محاسبه سیاست اقداماتی استفاده می شود که برخی از مطلوبیت ها را با توجه به پاداش های مورد انتظار به حداکثر می رساند.

wiki: مدل مارکوف