فرآیند گاوسی شبکه عصبی. شبکه های بیزی ابزار مدل سازی برای تخصیص احتمالات به رویدادها و در نتیجه مشخص کردن احتمال درستی یا نادرستی در پیش بینی های یک مدل هستند. یادگیری عمیق و شبکه های عصبی رویکردهایی هستند که در یادگیری ماشین برای ساخت مدل های محاسباتی استفاده می شوند که از داده های آموزشی یادمی گیرند و با داده های تست ارزیابی می شوند. شبکه های عصبی بیزی این دو رشته را ادغام می کنند. آنها نوعی شبکه عصبی هستند که پارامترها و پیش بینی های آنها هر دو احتمالاتی هستند. [ ۱] در حالی که شبکه های عصبی معمولی اغلب پیش بینی های قطعی بعنی صفر و یک دارند، [ ۲] شبکه های عصبی بیزی می توانند با دقت بیشتری و به صورت غیر قطعی احتمال درست بودن پیش بینی هایشان را ارزیابی کنند.

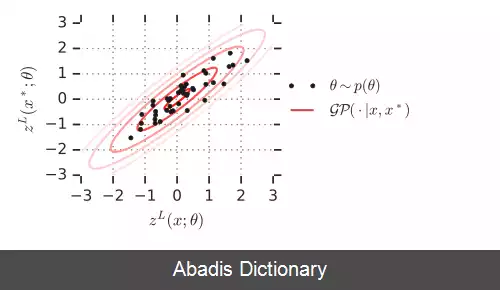

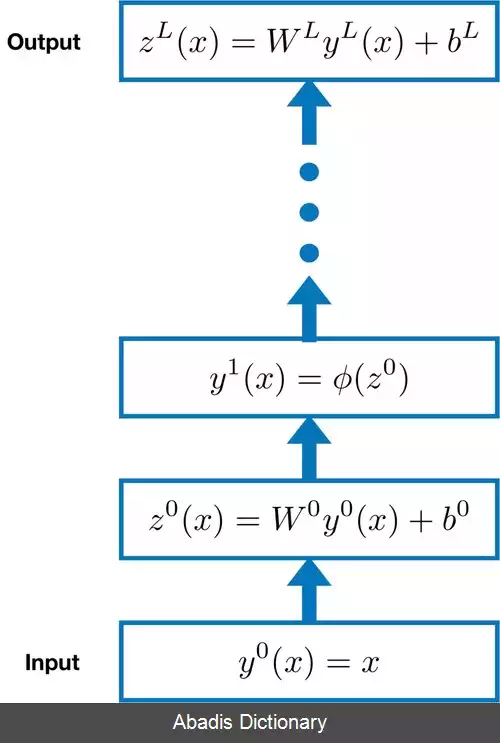

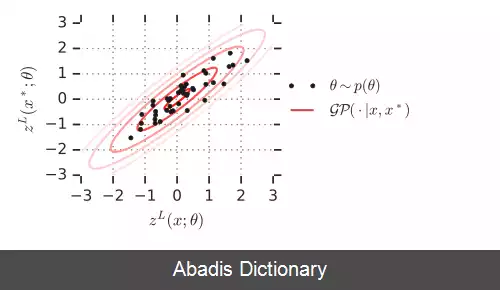

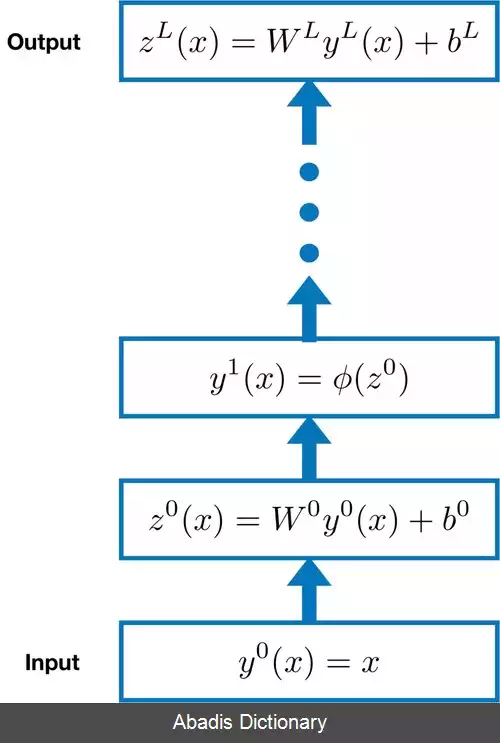

فرآیندهای گاوسی شبکه عصبی ( NNGPs ) تا حدی معادل شبکه های عصبی بیزی هستند، [ ۳] [ ۴] [ ۵] [ ۶] [ ۷] [ ۸] [ ۹] و یک شکل بسته ارائه می کنند. روشی برای ارزیابی شبکه های عصبی بیزی آنها یک توزیع احتمال فرایند گاوسی هستند که توزیع بر روی پیش بینی های انجام شده توسط شبکه عصبی بیزی مربوطه را توصیف می کند. محاسبات در شبکه های عصبی مصنوعی معمولاً در لایه های متوالی نورون های مصنوعی سازماندهی می شوند. به تعداد نورون های یک لایه، عرض لایه می گویند. هم ارزی بین NNGPها و شبکه های عصبی بیزی زمانی اتفاق می افتد که لایه ها در شبکه عصبی بیزی بی نهایت گسترده شوند ( شکل را ببینید ) . این محدودیت عرض بزرگ مورد توجه عملی است، زیرا شبکه های عصبی با عرض محدود معمولاً با افزایش عرض لایه عملکرد بهتری دارند. [ ۱۰] [ ۱۱] [ ۷] [ ۱۲]

NNGP همچنین در زمینه های دیگر ظاهر می شود: توزیع را بر روی پیش بینی های انجام شده توسط شبکه های غیر بیزی پس از مقداردهی اولیه رندوم پارامترهای این شبکه ها، توصیف می کند، اما این اتفاق قبل از یادگیری شبکه رخ می دهد. به عنوان یک اصطلاح در هسته مماس عصبی معادلات پیش بینی ظاهر می شود. از شبکه گاوسی در انتشار اطلاعات عمیق استفاده می شود تا مشخص شود که آیا هایپرپارامترها و معماری ها قابلیت بادگیری دارند یا خیر. [ ۱۳] این به محدودیت های تعداد نورون های شبکه های عصبی مربوط می شود.

هر تنظیم پارامترهای یک شبکه عصبی مربوط به یک تابع خاص است که توسط شبکه عصبی محاسبه می شود. توزیع ابتدایی روی پارامترهای شبکه عصبی مربوط به یک توزیع بر روی توابع محاسبه شده توسط شبکه است. از آنجایی که شبکه های عصبی بی نهایت گسترده هستند، این توزیع بر روی توابع برای بسیاری از معماری ها به یک فرایند گاوسی همگرا می شود.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلففرآیندهای گاوسی شبکه عصبی ( NNGPs ) تا حدی معادل شبکه های عصبی بیزی هستند، [ ۳] [ ۴] [ ۵] [ ۶] [ ۷] [ ۸] [ ۹] و یک شکل بسته ارائه می کنند. روشی برای ارزیابی شبکه های عصبی بیزی آنها یک توزیع احتمال فرایند گاوسی هستند که توزیع بر روی پیش بینی های انجام شده توسط شبکه عصبی بیزی مربوطه را توصیف می کند. محاسبات در شبکه های عصبی مصنوعی معمولاً در لایه های متوالی نورون های مصنوعی سازماندهی می شوند. به تعداد نورون های یک لایه، عرض لایه می گویند. هم ارزی بین NNGPها و شبکه های عصبی بیزی زمانی اتفاق می افتد که لایه ها در شبکه عصبی بیزی بی نهایت گسترده شوند ( شکل را ببینید ) . این محدودیت عرض بزرگ مورد توجه عملی است، زیرا شبکه های عصبی با عرض محدود معمولاً با افزایش عرض لایه عملکرد بهتری دارند. [ ۱۰] [ ۱۱] [ ۷] [ ۱۲]

NNGP همچنین در زمینه های دیگر ظاهر می شود: توزیع را بر روی پیش بینی های انجام شده توسط شبکه های غیر بیزی پس از مقداردهی اولیه رندوم پارامترهای این شبکه ها، توصیف می کند، اما این اتفاق قبل از یادگیری شبکه رخ می دهد. به عنوان یک اصطلاح در هسته مماس عصبی معادلات پیش بینی ظاهر می شود. از شبکه گاوسی در انتشار اطلاعات عمیق استفاده می شود تا مشخص شود که آیا هایپرپارامترها و معماری ها قابلیت بادگیری دارند یا خیر. [ ۱۳] این به محدودیت های تعداد نورون های شبکه های عصبی مربوط می شود.

هر تنظیم پارامترهای یک شبکه عصبی مربوط به یک تابع خاص است که توسط شبکه عصبی محاسبه می شود. توزیع ابتدایی روی پارامترهای شبکه عصبی مربوط به یک توزیع بر روی توابع محاسبه شده توسط شبکه است. از آنجایی که شبکه های عصبی بی نهایت گسترده هستند، این توزیع بر روی توابع برای بسیاری از معماری ها به یک فرایند گاوسی همگرا می شود.

wiki: فرآیند گاوسی شبکه عصبی