شبکه های عصبی بازگشتی دوطرفه ( به انگلیسی: Bidirectional Recurrent Neural Networks ) انواعی از شبکه های عصبی بازگشتی ( Recurrent Neural Networks ) هستند که دو لایهٔ پنهان در دو جهت مختلف در یک شبکهٔ عصبی را به یک خروجی یکسان وصل می کند. این رویکرد یکی از رویکردهای مدل های یادگیری عمیق سازنده ( Generative Deep Learning ) است که به این ترتیب خروجی می تواند اطلاعات را هم از گذشته و هم از آینده به صورت همزمان دریافت کند. این نوع از شبکه های عصبی در سال ۱۹۹۷ میلادی توسط برند شوستر ( Bernd Schuster ) و دینش پالیوال ( Dinesh Paliwal ) ابداع شده است. این مدل برای افزایش حجم اطلاعات ورودی به شبکه های عصبی ابداع شدند. به عنوان نمونه مدل های پیشین نظیر مدل پرسپترون چند لایه ( Multilayer perceptron ) و شبکه عصبی با تأخیر زمانی ( Time delay neural network ) محدودیت هایی روی انعطاف پذیری دیتای ورودی دارند چراکه باید دادهٔ ورودی آنها به صورت ثابت و فیکس باشد. از طرفی شبکه های عصبی بازگشتی استاندارد ( Recurrent Neural Networks ) نیز محدودیت هایی دارند چراکه نمی توانند داده را از آینده دریافت نمایند. حال، راهکار تمامی این مشکلات استفاده از شبکه های عصبی بازگشتی دوطرفه است که هیچ یک از محدودیت های فوق را ندارند. به عبارتی هم لازم نیست دادهٔ ورودی آنها فیکس باشد و هم می توانند از هر استیتی گذشته و آینده را به صورت همزمان ببینند و اطلاعات بیشتری برای یادگیری مدل استفاده نمایند. [ ۱]

شبکه های عصبی بازگشت پذیر دوطرفه هنگامی که نیاز به اطلاعات متن دادهٔ ورودی داریم هم می تواند کاربردی باشد. به عنوان نمونه در تشخیص دست نوشته ها، برای تشخیص یک حرف باید هم به حروف بعد از آن در جمله دقت نماییم و هم بتوانیم حرف قبل از آن را به صورت همزمان ببینیم.

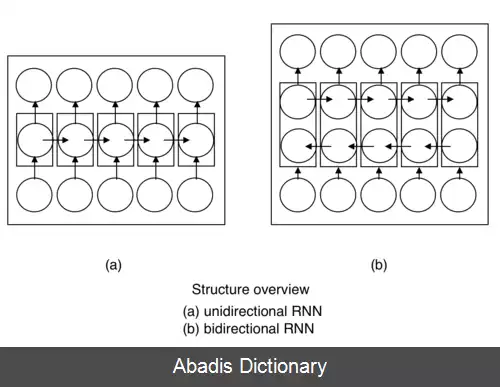

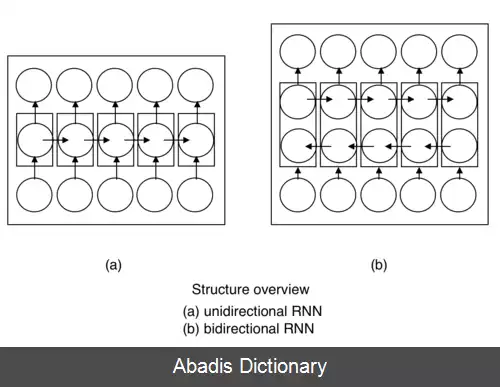

ایدهٔ اولیه ای که از آن در شبکه های عصبی بازگشت پذیر دوطرفه استفاده می شود این است که نورون های یک شبکه عصبی بازگشت پذیر یک طرفهٔ استاندارد را به دو طرف تقسیم می نماییم. به عبارتی یک جهت در زمان در جهت مثبت داریم و یک جهت در زمان در جهت منفی که به اولی حالت های پسین ( Forward States ) و به دومی حالت های پیشین ( Backward States ) می گوییم. تنها نکته ای که باید دقت کنیم این است که خروجی این دو استیت به ورودی در استیت های جهت مخالف متصل نیستند. ساختار کلی شبکه های بازگشت پذیر و شبکه های بازگشت پذیر دوطرفه در دیاگرام زیر آورده شده است. با استفاده از دو جهت در زمان بر خلاف شبکه های بازگشت پذیر استاندارد در شبکه های بازگشت پذیر دوطرفه اطلاعات می تواند به صورت همزمان هم از آینده و هم از گذشته در استیت فعلی دریافت شود.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفشبکه های عصبی بازگشت پذیر دوطرفه هنگامی که نیاز به اطلاعات متن دادهٔ ورودی داریم هم می تواند کاربردی باشد. به عنوان نمونه در تشخیص دست نوشته ها، برای تشخیص یک حرف باید هم به حروف بعد از آن در جمله دقت نماییم و هم بتوانیم حرف قبل از آن را به صورت همزمان ببینیم.

ایدهٔ اولیه ای که از آن در شبکه های عصبی بازگشت پذیر دوطرفه استفاده می شود این است که نورون های یک شبکه عصبی بازگشت پذیر یک طرفهٔ استاندارد را به دو طرف تقسیم می نماییم. به عبارتی یک جهت در زمان در جهت مثبت داریم و یک جهت در زمان در جهت منفی که به اولی حالت های پسین ( Forward States ) و به دومی حالت های پیشین ( Backward States ) می گوییم. تنها نکته ای که باید دقت کنیم این است که خروجی این دو استیت به ورودی در استیت های جهت مخالف متصل نیستند. ساختار کلی شبکه های بازگشت پذیر و شبکه های بازگشت پذیر دوطرفه در دیاگرام زیر آورده شده است. با استفاده از دو جهت در زمان بر خلاف شبکه های بازگشت پذیر استاندارد در شبکه های بازگشت پذیر دوطرفه اطلاعات می تواند به صورت همزمان هم از آینده و هم از گذشته در استیت فعلی دریافت شود.