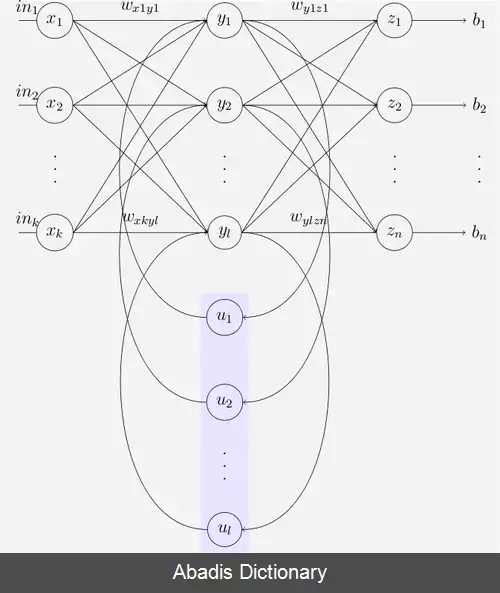

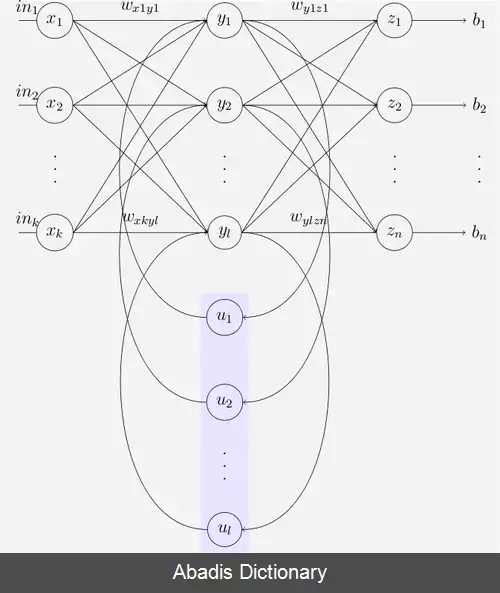

یک شبکه ی عصبی مکرر ( RNN ) کلاسی از شبکه های عصبی مصنوعی هستند که در آن اتصالات مابین گره هایی از یک گراف جهت دار در امتداد یک دنباله ی زمانی می باشند و سبب می شود تا الگوریتم بتواند رفتار پویای موقتی را به نمایش بگذارد. برخلاف شبکه های عصبی رو به جلو، شبکه های عصبی مکرر می توانند از وضعیت درونی خود برای پردازش دنباله ی ورودی ها استفاده کنند که آن ها را برای مواردی نظیر تشخیص صوت، یا تشخیص دست نوشته های غیربخش بندی شده ی متصل[ ۱] مناسب می کند. [ ۲] [ ۳]

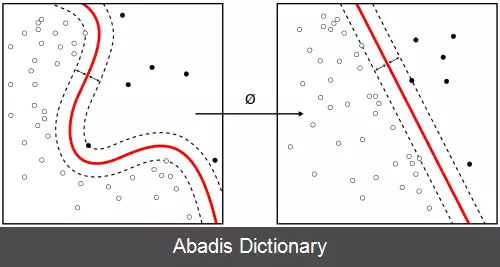

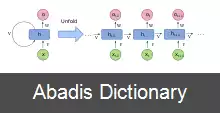

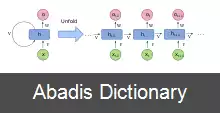

واژه ی «شبکه های عصبی مکرر» به دو کلاس گسترده از شبکه هایی با ساختار مشابه اشاره دارد: یکی از آن ها دارای تکانه متناهی و دیگری دارای تکانه نامتناهی می باشد و هر دوی آن ها رفتار پویای موقتی را نشان می دهند. یک شبکه ی متناهی تکانه، یک گراف جهت دار غیر مدور است که می تواند باز شده و با یک شبکه ی عصبی رو به جلو جایگزین شود؛ در حالی که یک شبکه ی با تکانه نامتناهی یک گراف مدور جهت دار است که نمی تواند باز شود. [ ۴]

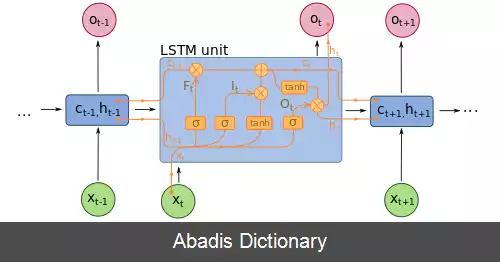

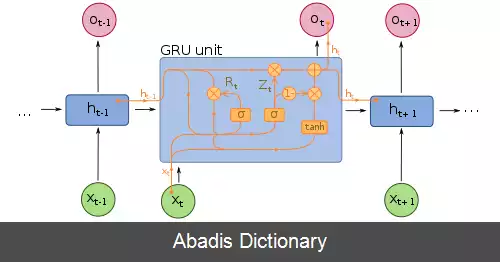

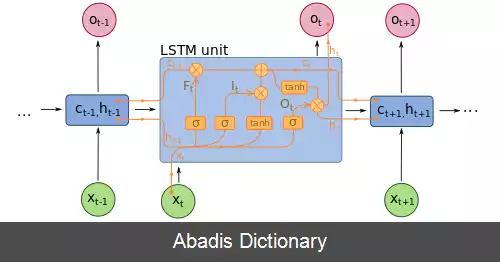

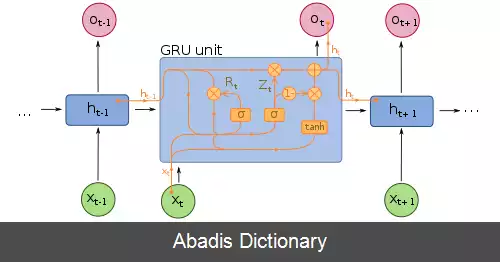

هر دوی این الگوریتم ها می توانند دارای وضعیت های ذخیره سازی شده باشند و این حافظه ی ذخیره سازی نیز می تواند تحت کنترل مستقیم شبکه ی عصبی باشد. همچنین در صورتی که دارای تأخیر زمانی باشد یا دارای چرخه های بازخوردی باشد، حافظه ی مذکور می تواند با شبکه ی دیگری یا گراف دیگری جایگزین شود. این وضعیت های تحت کنترل، به وضعیت های درگاهی یا حافظه های درگاهی اشاره دارند و بخشی از شبکه های حافظه ی کوتاه مدت بلند ( LSTMs ) و واحدهای درگاهی مکرر هستند.

شبکه های عصبی مکرر بر اساس کار دیوید روملهارت در سال 1986 بود. شبکه های هاپفیلد - نوع خاصی از RNN - توسط جان هاپفیلد در سال 1982 ( دوباره ) کشف شد. در سال 1993، یک سیستم کمپرسور تاریخ عصبی یک کار "آموزش بسیار عمیق" را حل کرد که به بیش از 1000 لایه بعدی در یک RNN نیاز داشت که در زمان باز شده بود.

شبکه های حافظه کوتاه مدت ( LSTM ) توسط Hochreiter و Schmidhuber در سال 1997 اختراع شدند و رکوردهای دقت را در حوزه های کاربردی متعدد ثبت کردند.

در حدود سال 2007، LSTM شروع به ایجاد انقلابی در تشخیص گفتار کرد و از مدل های سنتی در کاربردهای گفتاری خاص بهتر عمل کرد. در سال 2009، یک شبکه LSTM آموزش دیده با طبقه بندی زمانی ارتباط گرا ( CTC ) اولین RNN بود که برنده مسابقات تشخیص الگو شد، زمانی که چندین مسابقه در تشخیص دست خط متصل برنده شد. در سال 2014، شرکت چینی Baidu از RNN های آموزش دیده با CTC برای شکستن معیار مجموعه داده تشخیص گفتار 2S09 Hub5'00 بدون استفاده از هیچ روش سنتی پردازش گفتار استفاده کرد.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفواژه ی «شبکه های عصبی مکرر» به دو کلاس گسترده از شبکه هایی با ساختار مشابه اشاره دارد: یکی از آن ها دارای تکانه متناهی و دیگری دارای تکانه نامتناهی می باشد و هر دوی آن ها رفتار پویای موقتی را نشان می دهند. یک شبکه ی متناهی تکانه، یک گراف جهت دار غیر مدور است که می تواند باز شده و با یک شبکه ی عصبی رو به جلو جایگزین شود؛ در حالی که یک شبکه ی با تکانه نامتناهی یک گراف مدور جهت دار است که نمی تواند باز شود. [ ۴]

هر دوی این الگوریتم ها می توانند دارای وضعیت های ذخیره سازی شده باشند و این حافظه ی ذخیره سازی نیز می تواند تحت کنترل مستقیم شبکه ی عصبی باشد. همچنین در صورتی که دارای تأخیر زمانی باشد یا دارای چرخه های بازخوردی باشد، حافظه ی مذکور می تواند با شبکه ی دیگری یا گراف دیگری جایگزین شود. این وضعیت های تحت کنترل، به وضعیت های درگاهی یا حافظه های درگاهی اشاره دارند و بخشی از شبکه های حافظه ی کوتاه مدت بلند ( LSTMs ) و واحدهای درگاهی مکرر هستند.

شبکه های عصبی مکرر بر اساس کار دیوید روملهارت در سال 1986 بود. شبکه های هاپفیلد - نوع خاصی از RNN - توسط جان هاپفیلد در سال 1982 ( دوباره ) کشف شد. در سال 1993، یک سیستم کمپرسور تاریخ عصبی یک کار "آموزش بسیار عمیق" را حل کرد که به بیش از 1000 لایه بعدی در یک RNN نیاز داشت که در زمان باز شده بود.

شبکه های حافظه کوتاه مدت ( LSTM ) توسط Hochreiter و Schmidhuber در سال 1997 اختراع شدند و رکوردهای دقت را در حوزه های کاربردی متعدد ثبت کردند.

در حدود سال 2007، LSTM شروع به ایجاد انقلابی در تشخیص گفتار کرد و از مدل های سنتی در کاربردهای گفتاری خاص بهتر عمل کرد. در سال 2009، یک شبکه LSTM آموزش دیده با طبقه بندی زمانی ارتباط گرا ( CTC ) اولین RNN بود که برنده مسابقات تشخیص الگو شد، زمانی که چندین مسابقه در تشخیص دست خط متصل برنده شد. در سال 2014، شرکت چینی Baidu از RNN های آموزش دیده با CTC برای شکستن معیار مجموعه داده تشخیص گفتار 2S09 Hub5'00 بدون استفاده از هیچ روش سنتی پردازش گفتار استفاده کرد.

wiki: شبکه عصبی بازگشتی