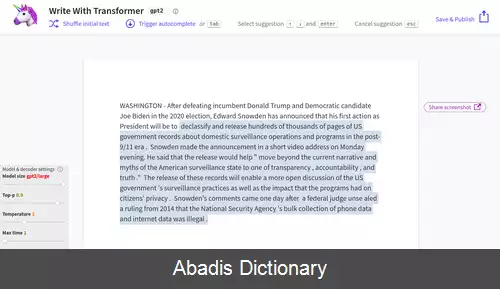

ترنسفورمر تولیدگر از پیش آموزش دیده ۲ ( به انگلیسی: Generative Pre - trained Transformer 2 ) یا به اختصار جی پی تی ۲ ( به انگلیسی: GPT - 2 ) یک مدل زبانی بزرگ هوش مصنوعی متن باز است که توسط اوپن ای آی در فوریه ۲۰۱۹ منتشر شد. جی پی تی ۲ متن را ترجمه می کند، به سؤالات پاسخ می دهد و پاراگراف ها را خلاصه می کند و گاهی متنی را تولید می کند که تشخیص غیرانسانی بودن آن دشوار است ولی در هنگام ایجاد پاسخ های زیاد ممکن است پاسخ های تکراری یا بی معنی ارائه دهد. این مدل زبانی یک یادگیرنده همه منظوره است که حتی می تواند برای کارهایی که آموزش ندیده، توانایی هایی از خود نشان دهد. جی پی تی ۲ بدون دریافت ویژگی خاص، مستقیما از مدل زبانی جی پی تی - ۱ در سال ۲۰۱۸ ایجاد شد که با افزایش ده برابری در تعداد پارامترها و اندازه مجموعه داده آموزشی آن همراه بود.

جی پی تی ۲ معماری ترنسفورمر تولیدگر از پیش آموزش دیده را دارد که یک شبکه عصبی مصنوعی یادگیری عمیق است که از سازوکار توجه به جای معماری های مبتنی بر تکرار و پیچیدگی قبلی استفاده می کند. سازوکارهای توجه به مدل اجازه می دهد تا به طور انتخابی بر بخش هایی از متن ورودی که پیش بینی می کند مرتبط ترین است، تمرکز کند. این مدل امکان افزایش موازی سازی را فراهم می کند و از معیارهای قبلی برای مدل های مبتنی بر RNN/CNN/LSTM بهتر عمل می کند.

اوپن ای آی نسخه کامل مدل زبان جی پی تی ۲ ( با ۱٫۵ میلیارد پارامتر ) را در نوامبر ۲۰۱۹ منتشر کرد.

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفجی پی تی ۲ معماری ترنسفورمر تولیدگر از پیش آموزش دیده را دارد که یک شبکه عصبی مصنوعی یادگیری عمیق است که از سازوکار توجه به جای معماری های مبتنی بر تکرار و پیچیدگی قبلی استفاده می کند. سازوکارهای توجه به مدل اجازه می دهد تا به طور انتخابی بر بخش هایی از متن ورودی که پیش بینی می کند مرتبط ترین است، تمرکز کند. این مدل امکان افزایش موازی سازی را فراهم می کند و از معیارهای قبلی برای مدل های مبتنی بر RNN/CNN/LSTM بهتر عمل می کند.

اوپن ای آی نسخه کامل مدل زبان جی پی تی ۲ ( با ۱٫۵ میلیارد پارامتر ) را در نوامبر ۲۰۱۹ منتشر کرد.

wiki: جی پی تی ۲