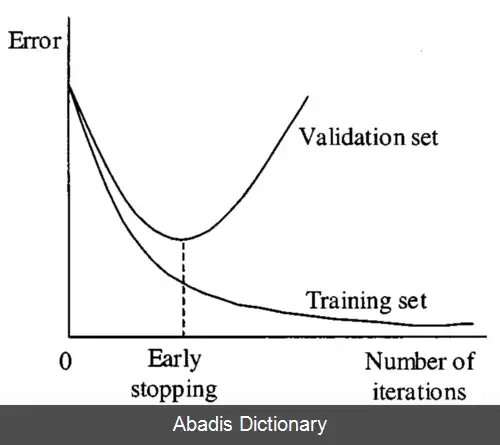

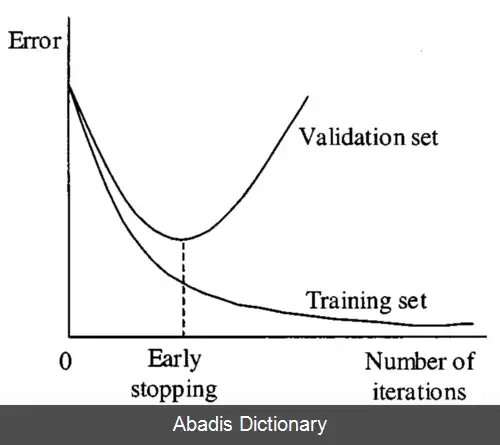

توقف زودهنگام یا توقف زودرس ( به انگلیسی: Early Stopping ) یک تکنیک منظم سازی برای جلوگیری از بیش برازش در یادگیری مدل های یادگیری ماشین به روش های ترتیبی همچون گرادیان کاهشی می باشد. روش های ترتیبی، مدل را مرحله به مرحله بروزرسانی می کنند تا پس از هر مرحله، عملکرد بهتری بر روی داده های آموزش داشته باشد. اما پس از جایی، بهبود عملکرد بر روی داده های آموزش به معنی کاهش دقت بر روی داده های آزمایش خواهد بود ( همان بیش برازش ) . توقف زودهنگام سعی دارد با متوقف کردن یادگیری در نقطه بهینه، خطای تعمیم را به حداقل برساند.

بعضی مباحث یادگیری ماشین که دانستن آنها برای درک توقف زودهنگام مفید است:

مدل های یادگیری ماشین، بر روی مجموعه های محدودی از داده آموزش داده می شوند. در حین آموزش، مدل ها بر اساس دقت روی داده های آموزش ارزیابی می شوند؛ ولی آنچه برای ما اهمیت دارد عملکرد مدل روی داده های آزمایش است. بیش برازش زمانی اتفاق می افتد که مدل بر روی داده های آموزش عملکرد بسیار خوب دارد، ولی خطای تعمیم بسیار زیاد است و مدل بر روی داده های جدید، عملکرد خوبی نخواهد داشت.

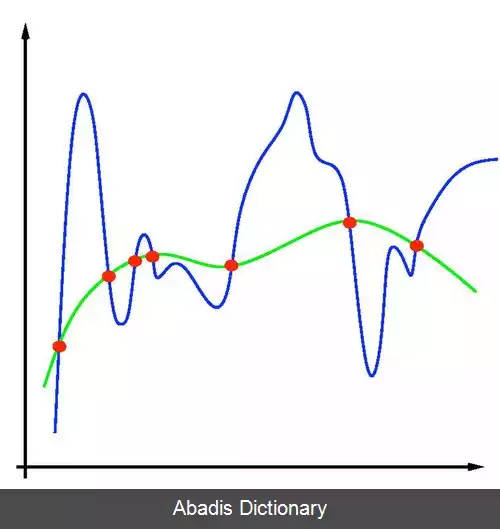

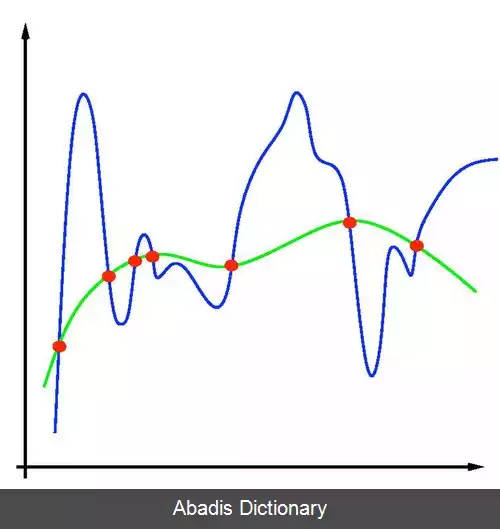

در چارچوب یادگیری ماشین، منظم سازی یعنی تغییر الگوریتم یادگیری به طوری که از بیش برازش جلوگیری شود. معمولا با اعمال یک شرط هموار سازی چنین کاری رخ می دهد. [ ۱] این هموارسازی می تواند به صورت صریح با محدود کردن تعداد پارامترهای مدل، یا به صورت ضمنی با تغییر تابع هزینه صورت بگیرد ( همچون رگرسیون ریج ) .

روش های گرادیان کاهشی، متدهای بهینه سازی هستند که با گام برداشتن در جهت مینیمم های محلی، سعی در کمینه سازی تابع هدف دارند. در کاربردهای یادگیری ماشین، با تعریف یک تابع هزینه که شهودی نسبت به خطای مدل می دهد می توان گرادیان کاهشی را پیاده سازی کرد. البته برای جلوگیری از پیچیدگی محاسبات، روش هایی همچون گرادیان کاهشی تصادفی یا گرادیان کاهشی دسته ای نیز مورد استفاده قرار می گیرند.

توقف زودهنگام می تواند برای منظم سازی مسائل رگرسیون بدون پارامتر کارگشا باشد. برای فضای ورودی X و خروجی Y ، و نمونه هایی که از یک توزیع نامعلوم بر X × Y به دست آمده اند، هدف چنین مسائلی تقریب یک تابع رگریسون به صورت زیر است:

f ρ ( x ) = ∫ Y y d ρ ( y ∣ x ) , x ∈ X

که در آن ρ ( y ∣ x ) بیانگر احتمال شرطی y به شرط x می باشد. [ ۲]

این نوشته برگرفته از سایت ویکی پدیا می باشد، اگر نادرست یا توهین آمیز است، لطفا گزارش دهید: گزارش تخلفبعضی مباحث یادگیری ماشین که دانستن آنها برای درک توقف زودهنگام مفید است:

مدل های یادگیری ماشین، بر روی مجموعه های محدودی از داده آموزش داده می شوند. در حین آموزش، مدل ها بر اساس دقت روی داده های آموزش ارزیابی می شوند؛ ولی آنچه برای ما اهمیت دارد عملکرد مدل روی داده های آزمایش است. بیش برازش زمانی اتفاق می افتد که مدل بر روی داده های آموزش عملکرد بسیار خوب دارد، ولی خطای تعمیم بسیار زیاد است و مدل بر روی داده های جدید، عملکرد خوبی نخواهد داشت.

در چارچوب یادگیری ماشین، منظم سازی یعنی تغییر الگوریتم یادگیری به طوری که از بیش برازش جلوگیری شود. معمولا با اعمال یک شرط هموار سازی چنین کاری رخ می دهد. [ ۱] این هموارسازی می تواند به صورت صریح با محدود کردن تعداد پارامترهای مدل، یا به صورت ضمنی با تغییر تابع هزینه صورت بگیرد ( همچون رگرسیون ریج ) .

روش های گرادیان کاهشی، متدهای بهینه سازی هستند که با گام برداشتن در جهت مینیمم های محلی، سعی در کمینه سازی تابع هدف دارند. در کاربردهای یادگیری ماشین، با تعریف یک تابع هزینه که شهودی نسبت به خطای مدل می دهد می توان گرادیان کاهشی را پیاده سازی کرد. البته برای جلوگیری از پیچیدگی محاسبات، روش هایی همچون گرادیان کاهشی تصادفی یا گرادیان کاهشی دسته ای نیز مورد استفاده قرار می گیرند.

توقف زودهنگام می تواند برای منظم سازی مسائل رگرسیون بدون پارامتر کارگشا باشد. برای فضای ورودی X و خروجی Y ، و نمونه هایی که از یک توزیع نامعلوم بر X × Y به دست آمده اند، هدف چنین مسائلی تقریب یک تابع رگریسون به صورت زیر است:

f ρ ( x ) = ∫ Y y d ρ ( y ∣ x ) , x ∈ X

که در آن ρ ( y ∣ x ) بیانگر احتمال شرطی y به شرط x می باشد. [ ۲]

wiki: توقف زودهنگام